转载:https://ai.zol.com.cn/888/8880638.html

2024-07-29 18:20:50·[??中关村在线 原创??]·作者:肖医

近期,以大语言模型(LLM)为基础的向量模型(embedding model)变得愈发流行。得益于大语言模型强大的语义理解能力,相关模型在下游任务中的检索精度得到了显著的提升。然而,当前基于大模型的向量模型(LLM-backended embedding model)仍然单纯依靠标签数据进行微调,缺乏灵活应对不同下游任务的能力。与此同时,当前的模型大都支持英文且主要面对向量检索任务(dense retrieval),相比之下,针对其他语言以及更多检索任务的模型较为不足。

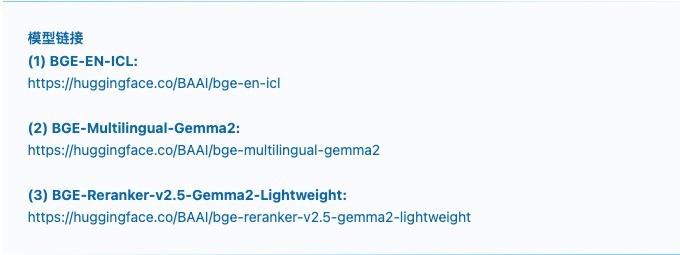

针对上述问题,智源研究院发布三款全新模型:英文向量模型BGE-EN-ICL,多语言向量模型BGE-Multilingual-Gemma2,多语言重排序模型BGE-Reranker-v2.5-Gemma2-Lightweight。这些模型进一步刷新了MTEB、BEIR、MIRACL、AIR-Bench等主要评测基准的最佳水平,同时借助情境学习(in-context learning)获得了出色的自适应能力,这为向量模型的进一步发展带来了新的可能性。

?1、特点

(1)基于大模型训练

智源推出的三款新模型均基于大语言模型进行训练,因而具备卓越的领域适应能力和广泛的泛化性能,使其能够在各种任务中展现出色的表现,适应不同应用场景的需求。

(2)情境学习能力

在以往的工作中,例如 e5-mistral-7b 和 SFR,虽然已经提出通过在查询前提供任务描述来提升查询嵌入的语义丰富性,但这些方法并未充分挖掘模型的上下文学习能力。为此,智源推出了 BGE-EN-ICL 模型。在查询端,除了提供任务描述外,还引入了任务相关的查询-文档示例作为少量示例(few-shot examples),这进一步增强了模型的语义表达能力,使其在复杂任务或是训练数据中所未见过的任务中表现更加优越。

(3)蒸馏技术

BGE-EN-ICL和BGE-Multilingual-Gemma2模型在检索数据集上采用重排器作为教师模型进行蒸馏训练。这不仅提升了模型的整体性能,还增强了其在检索任务中的能力,使其在面对多样化数据时更加高效。

(4)轻量化设计

针对用户对模型使用便捷性的需求,BGE-Reranker-v2.5-Gemma2-Lightweight模型在bge-reranker-v2-minicpm-layerwise的基础上进行了进一步优化。该模型不仅支持逐层提前输出,还能在前向传输过程中实现token压缩。这两种技术的结合大大节省了计算资源,同时保持了卓越的性能表现。

2、实验结果

A. 中英文能力

(1)MTEB

在MTEB榜单中,多语言模型BGE-Multilingual-Gemma2表现出色,而BGE-EN-ICL的few-shot表现尤为突出。

(2)BEIR

在BEIR榜单中,多语言模型BGE-Multilingual-Gemma2依然表现优异,而BGE-EN-ICL few-shot的结果更为出色。

基于bge-large-en-v1.5和e5-mistral-7b-instruct,BGE-Reranker-v2.5-Gemma2-Lightweight分别对它们的BEIR检索结果的top-100进行重排,达到了更好的结果,并在节省60% flops的情况下仍保证了优越的效果。

(3)AIR-Bench

在AIR-Bench上,BGE-Multilingual-Gemma2和BGE-EN-ICL表现出强大的泛化性,在新领域上表现优异,in-context learning能力进一步增强了BGE-EN-ICL的表现。

Long-doc:

QA-en:

QA-en&zh:

(4)C-MTEB

在中文任务即C-MTEB任务上,BGE-Multilingual-Gemma2的中文能力进一步增强,相比之前的bge-large-zh-v1.5有显著提升。

B. 多语言能力

(1)MIRACL

在多语言能力方面,BGE-Multilingual-Gemma2表现出显著优势,尤其在中英文能力提升方面表现突出。

BGE-Reranker-v2.5-Gemma2-Lightweight对bge-m3的MIRACL检索结果的top-100进行重排,达到了更好的结果,并在节省60% flops的情况下仍保证了优越的效果。

(2)MTEB-FR/PL

在MTEB的法语和波兰语榜单上,BGE-Multilingual-Gemma2表现尤为突出,展现其出色的多语言能力。

本文属于原创文章,如若转载,请注明来源:智源发布三款BGE新模型,再次刷新向量检索最佳水平https://ai.zol.com.cn/888/8880638.html

当前位置:新闻详细

当前位置:新闻详细